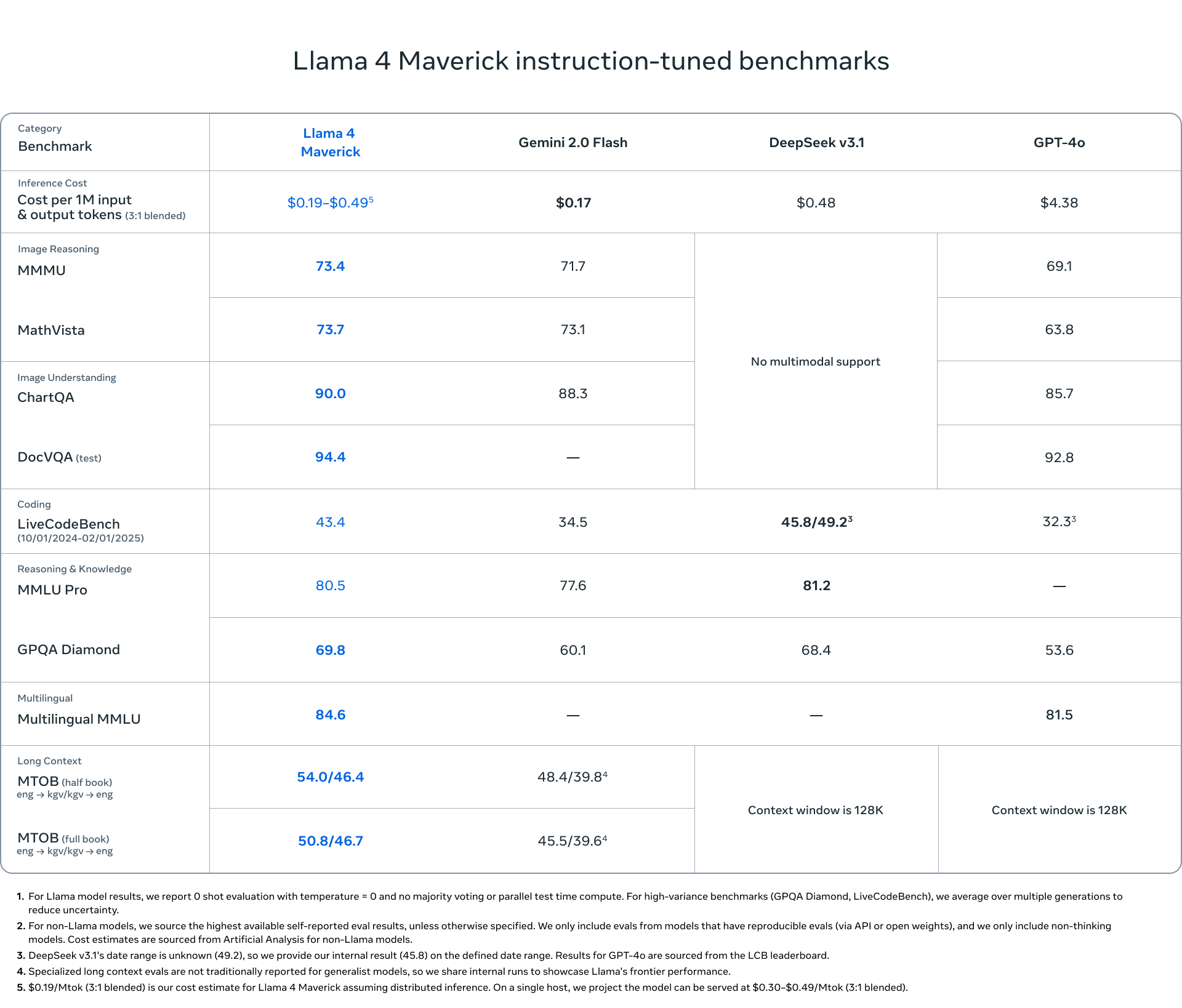

Meta susține că noile sale modele sunt superioare celor de la OpenAI și Google într-o „gamă largă” de benchmark-uri.

Urmărește cele mai noi producții video TechRider.ro

- articolul continuă mai jos -

Meta a anunțat Llama 4, cea mai nouă colecție a sa de modele AI care alimentează acum asistentul Meta AI pe web și în WhatsApp, Messenger și Instagram. Cele două modele noi, disponibile și pentru descărcare de pe Meta sau Hugging Face, sunt Llama 4 Scout — un model mic capabil să „se funcționeze cu un singur GPU Nvidia H100” — și Llama 4 Maverick, care seamănă mai mult cu GPT-4o și Gemini 2.0 Flash. Meta spune că este încă în plin proces de training (antrenare) pentru Llama 4 Behemoth, despre care CEO-ul Meta, Mark Zuckerberg, spune că este „cel mai performant model de bază din lume”.

Potrivit Meta, Llama 4 Scout are o fereastră de context de 10 milioane de tokenuri – fereastră de context = memoria de lucru a unui model AI – și depășește modelele Google Gemma 3 și Gemini 2.0 Flash-Lite, precum și modelul cu sursă deschisă-open source Mistral 3.1, „într-o gamă largă de benchmark-uri raportate pe scară largă”, în timp ce „încape într-un singur GPU H100”. Meta face afirmații similare cu privire la performanța modelului său mai mare Maverick față de GPT-4o de la OpenAI și Gemini 2.0 Flash de la Google și spune că rezultatele sale sunt comparabile cu DeepSeek-V3 în sarcinile de codificare și raționament folosind „mai puțin de jumătate din parametrii activi”.

Între timp, Llama 4 Behemoth are 288 de miliarde de parametri activi cu 2 trilioane de parametri în total. Deși nu a fost încă lansat, Meta spune că Behemoth își poate depăși concurenții (în acest caz GPT-4.5 și Claude Sonnet 3.7) „la mai multe benchmark-uri STEM”.

Pentru Llama 4, Meta spune că a trecut la o arhitectură „amestec de experți” (MoE), o abordare care conservă resursele utilizând doar părțile unui model care sunt necesare pentru o anumită sarcină. Compania intenționează să discute planurile viitoare pentru modele și produse AI la conferința sa LlamaCon, care are loc pe 29 aprilie.

Odată terminat antrenamentul, Meta a făcut referire la un proces special pe care l-a implementat pentru a face Llama 4 mai inteligent, mai util și mai capabil să gestioneze conversațiile, imaginile și raționamentele complexe. În special pentru Maverick, în loc să ofere modelului o mulțime de exemple simple, compania le-a filtrat și s-a concentrat pe solicitări mai complicate și mai provocatoare, forțându-l pe Maverick să gândească critic.

Reglarea fină pentru acest model a fost realizată în mai multe etape, de la o ușoară supraveghere până la învățare consolidată (reinforcement) online, apoi o rafinare finală pentru a îmbunătăți calitatea răspunsului. Făcând acest lucru, Meta crede că acum face din Llama 4 Maverick o AI echilibrată, de uz general, capabilă să înțeleagă imagini, să rezolve probleme și să poarte conversații naturale fără eficiență redusă în limbaj.

Aceste progrese vin pe lângă îmbunătățirile cheie de la generația anterioară, deoarece Llama 4 de la Meta introduce capabilități mult peste cele găsite în Llama 3. Spre deosebire de predecesorul său, Llama 4 de la Meta a fost proiectat cu multimodalitate nativă. De asemenea, utilizează fuziunea timpurie pentru a combina simbolurile de viziune și text într-un singur model, permițându-i, sperăm, să suporte mai bine aplicațiile bazate pe imagini.

Alte îmbunătățiri includ lungimi de context mai extraordinare (Scout este capabil să aibă o lungime de context de 10 milioane), performanță mai bună de referință și suport pentru mai multe date multilingve (acum acoperă 200 de limbi).

Oricum, Meta crede că noul său model AI va introduce mai multe experiențe interactive pe care le avem cu agenții și aplicațiile AI. Acestea includ asistenți generali de inteligență artificială, fluxuri de lucru ale întreprinderii, servicii care trebuie să proceseze și să înțeleagă atât imaginile, cât și textul, pentru a fi utilizate în codarea vibe sau chiar pentru a ajuta la o mai bună comunicare cu cei din întreaga lume.

Ca și în cazul modelelor sale anterioare, Meta numește colecția Llama 4 „open-source”, deși Llama a fost criticată pentru restricțiile de licență. De exemplu, licența Llama 4 cere entităților comerciale cu peste 700 de milioane de utilizatori activi lunar să solicite permisiunea de la Meta înainte de a folosi modelele, ceea ce Open Source Initiative a scris în 2023 o scoate „din categoria „Open Source”.

Llama 4 Scout și Llama 4 Maverick pot fi descărcate de pe Hugging Face și Llama.com. Meta spune că AI-ul său va fi acum alimentat de aceste modele începând de astăzi.