Pentru a răspunde preocupărilor legate de consumul de energie al centrelor de date care susțin infrastructura inteligenței artificiale, furnizorul de servicii cloud hyperscale (CSP) Cloudflare testează diverse acceleratoare AI care nu sunt GPU-uri AI de la AMD sau Nvidia, relatează Wall Street Journal. Recent, compania a început să testeze soluția Atlas de la Positron AI, care promite să depășească Nvidia H200 cu doar 33% din consumul său de energie.

Urmărește cele mai noi producții video TechRider.ro

- articolul continuă mai jos -

Positron propune o soluție ASIC pentru inferență care oferă o eficiență energetică crescută

Un ASIC (Application-Specific Integrated Circuit) este un circuit integrat special conceput pentru o anumită aplicație. Spre deosebire de circuitele integrate cu scop general, un ASIC este optimizat pentru a realiza o singură sarcină specifică, cum ar fi mineritul de criptomonede sau în cazul soluției Positron, pentru inferență AI.

Positron este o companie cu sediul în SUA, fondată în 2023, care dezvoltă acceleratoare AI axate exclusiv pe inferență. Spre deosebire de GPU-urile de uz general, care sunt proiectate pentru antrenarea AI, inferența AI, calculul tehnic și o gamă largă de alte sarcini, hardware-ul Positron este construit de la zero pentru a efectua sarcini de inferență în mod eficient și cu un consum minim de energie. Soluția de primă generație a Position AI pentru modele de transformatoare la scară largă se numește Atlas. Aceasta include opt acceleratoare Archer și este concepută pentru a depăși sistemele bazate pe Hopper de la Nvidia, consumând doar o fracțiune din energie, potrivit TomsHardware.

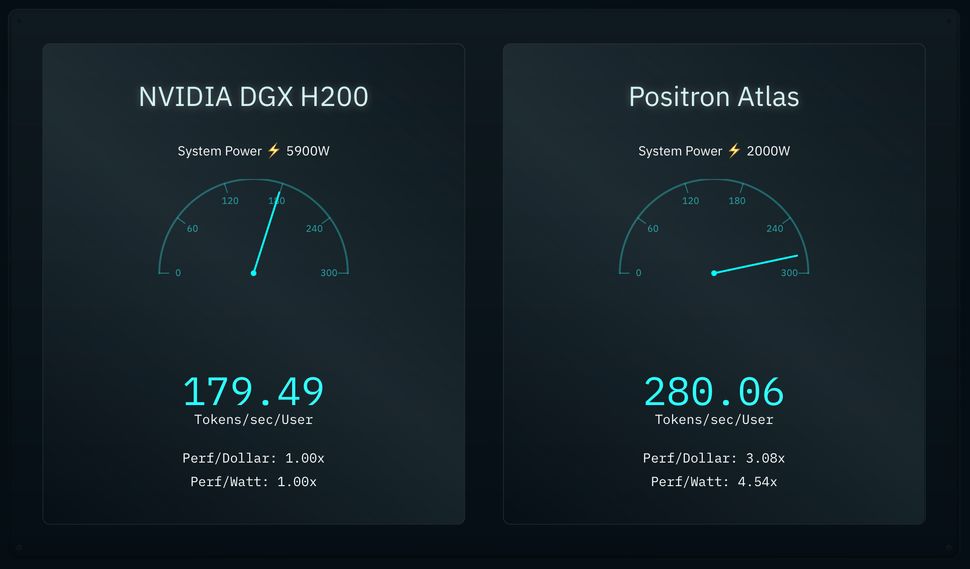

Atlas de la Positron AI poate livra aproximativ 280 de tokenuri pe secundă per utilizator în Llama 3.1 8B cu calcul BF16 la 2000 W, în timp ce un server Nvidia DGX H200 poate atinge doar aproximativ 180 de tokenuri pe secundă per utilizator în același scenariu, consumând o putere impresionantă de 5900 W, conform unei comparații efectuate de Positron AI. Acest lucru ar face Atlas de trei ori mai eficient în ceea ce privește performanța pe watt și performanța pe dolar în comparație cu sistemul DGX H200 al Nvidia. Această afirmație, desigur, necesită verificarea de către un evaluator independent.

Este de remarcat faptul că Positron AI produce hardware-ul ASIC la Fab 21 al TSMC din Arizona (utilizând o tehnologie de proces N4 sau N5), iar cardurile sunt asamblate tot în SUA. Totuși, deoarece acest ASIC este combinat cu memorie HBM și utilizează o tehnologie avansată de ambalare, este probabil ca o parte a procesului să fie realizată în Taiwan.

Sistemele Atlas și acceleratoarele Archer AI ale Positron AI sunt compatibile cu instrumente AI utilizate pe scară largă, precum Hugging Face, și răspund la cererile de inferență printr-un punct final compatibil cu API-ul OpenAI, permițând utilizatorilor să le adopte fără modificări majore ale fluxurilor de lucru.

Compania lucrează la acceleratorul de inferență AI de a doua generație denumit Asimov

Positron a strâns peste 75 de milioane de dolari în finanțare totală, inclusiv o rundă recentă de 51,6 milioane de dolari condusă de investitori precum Valor Equity Partners, Atreides Management și DFJ Growth. Compania lucrează, de asemenea, la acceleratorul de inferență AI de a doua generație, denumit Asimov, asamblate într-o platforma numită Titan care se așteaptă să concureze în 2026 cu sistemele de inferență bazate pe platformele Vera Rubin ale Nvidia.

Acceleratorul AI Asimov al Positron AI va avea 2 TB de memorie per ASIC și, pe baza unei imagini publicate de companie, nu va mai utiliza HBM, ci un alt tip de memorie. ASIC-ul va dispune, de asemenea, de o lățime de bandă de rețea externă de 16 Tb/s pentru operațiuni mai eficiente în sistemele la scară de rack. Titan, bazat pe opt acceleratoare Asimov AI este de așteptat să poată rula modele cu până la 16 trilioane de parametri pe o singură mașină, extinzând semnificativ limitele contextuale pentru aplicațiile AI generative la scară largă. Sistemul suportă, de asemenea, execuția simultană a mai multor modele, eliminând constrângerea unui singur model per GPU, potrivit Positron AI.

Cererea tot mai mare de energie din industria AI ridică semnale de alarmă, deoarece unele clustere masive utilizate pentru antrenarea modelelor AI consumă aceeași cantitate de energie cât un oraș. Situația se înrăutățește pe măsură ce modelele AI devin mai mari și utilizarea AI crește, ceea ce înseamnă că și consumul de energie al centrelor de date AI utilizate pentru inferență crește într-un ritm rapid. Cloudflare se numără printre primii utilizatori care testează în prezent hardware-ul de la Positron AI. Alte companii precum Google, Meta și Microsoft dezvoltă propriile acceleratoare de inferență pentru a-și menține consumul de energie sub control.