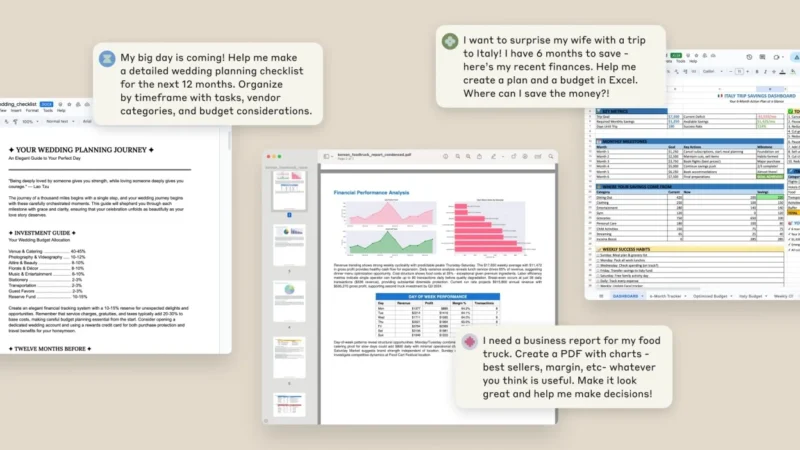

Anthropic a lansat o actualizare mică, dar semnificativă, pentru Claude. Începând de marți, puteți utiliza chatbotul pentru a crea și edita foi de calcul Excel, documente, prezentări PowerPoint și fișiere PDF. În trecut, Claude oferea suport rudimentar pentru fișiere, dar acum puteți interacționa cu orice documente pe care trebuie să le modificați direct prin chatbot. Noua funcționalitate face parte dintr-o previzualizare a funcției pe care o puteți încerca atâta timp cât aveți un abonament Max, Team sau Enterprise. Previzualizarea va fi lansată pentru abonații Pro „în următoarele săptămâni”, fără a exista încă un calendar pentru momentul în care utilizatorii gratuiți vor avea acces la ea.

Urmărește cele mai noi producții video TechRider.ro

- articolul continuă mai jos -

Anthropic a făcut anunțul pe blogul său, explicând că noile funcții sunt disponibile pe platforma sa destinată consumatorilor, Claude.ai.

Deși funcția poate fi utilă pentru utilizatorii Claude, documentația de asistență a companiei avertizează că „poate pune datele dvs. în pericol” potrivit ArsTechnica și detaliază modul în care asistentul AI poate fi manipulat pentru a transmite datele utilizatorilor către servere externe.

Experții consideră că sfaturile de securitate „externalizează în mod nedrept problema către utilizatorii Anthropic”

Funcția, denumită în mod ciudat „Creare și analiză îmbunătățită a fișierelor”, este răspunsul Anthropic la Code Interpreter de la ChatGPT și o versiune îmbunătățită a instrumentului de analiză al Anthropic.

Problema de securitate provine din faptul că noua funcție îi oferă lui Claude acces la un mediu de calcul sandbox, care îi permite să descarce pachete și să execute cod pentru a crea fișiere. „Această funcție îi oferă lui Claude acces la internet pentru a crea și analiza fișiere, ceea ce poate pune datele dvs. în pericol”, scrie Anthropic în anunțul de pe blogul său. „Monitorizați cu atenție chat-urile atunci când utilizați această funcție.”

Conform documentației Anthropic, un infractor cibernetic care manipulează această funcție ar putea „adăuga în mod discret instrucțiuni prin fișiere externe sau site-uri web” care manipulează Claude pentru a „citi date sensibile dintr-o sursă de cunoștințe conectată la claude.ai” și „utiliza mediul sandbox pentru a efectua o solicitare de rețea externă pentru a divulga datele”.

Aceasta descrie un atac de injectare a prompturilor, în care instrucțiuni ascunse încorporate în conținut aparent inofensiv pot manipula comportamentul modelului AI, o vulnerabilitate pe care cercetătorii în domeniul securității au documentat-o pentru prima dată în 2022. Aceste atacuri reprezintă o vulnerabilitate de securitate periculoasă și greu spre imposibil de nerezolvat a modelelor lingvistice AI, deoarece atât datele, cât și instrucțiunile privind modul de procesare a acestora sunt transmise modelului în același format, ca parte a „ferestrei de context”, ceea ce face dificilă pentru AI distingerea între instrucțiunile legitime și comenzile rău intenționate ascunse în conținutul furnizat de utilizator.

Compania afirmă în documentația sa de securitate că a descoperit vulnerabilitățile noii funcții prin testarea echipei de securitate înainte de lansare. Măsura de atenuare recomandată de Anthropic pentru utilizatori este „monitorizarea lui Claude în timp ce utilizați funcția și oprirea acesteia dacă observați că utilizează sau accesează date în mod neașteptat”, deși acest lucru plasează întreaga responsabilitate pentru securitate pe umerii utilizatorului, într-un sistem comercializat ca fiind automatizat și fără intervenție manuală.

Cercetătorul independent în domeniul AI, Simon Willison, analizând funcția pe blogul său, a remarcat că sfatul Anthropic de a „monitoriza Claude în timp ce utilizați funcția” echivalează cu „externalizarea nedreaptă a problemei către utilizatorii Anthropic”.

Măsuri luate de Anthropic

Anthropic încearcă totuși să rezolve problema. Compania a implementat mai multe măsuri de securitate pentru funcția de creare a fișierelor. Pentru utilizatorii Pro și Max, Anthropic a dezactivat partajarea publică a conversațiilor care utilizează funcția de creare a fișierelor. Pentru utilizatorii Enterprise, compania a implementat izolarea sandbox, astfel încât mediile să nu fie niciodată partajate între utilizatori. Compania a limitat, de asemenea, durata sarcinilor și timpul de rulare al containerului „pentru a evita buclele de activități rău intenționate”.

Pentru administratorii Team și Enterprise, Anthropic oferă, de asemenea, o listă de domenii la care Claude poate avea acces, inclusiv api.anthropic.com, github.com, registry.npmjs.org și pypi.org.

Documentația precizează că „Claude poate fi păcălit să divulge date la care are acces într-o conversație doar prin intermediul promptului unui utilizator individual, al unui proiect sau al conexiunilor activate”.

Documentația Anthropic precizează că compania are „un proces continuu de testare a securității și de red-teaming al acestei funcții”. Compania încurajează organizațiile să „evalueze aceste protecții în raport cu cerințele lor specifice de securitate atunci când decid dacă să activeze această funcție”.

Injecția prompturilor un pericol constant

Chiar și cu măsurile de securitate ale Anthropic, se recomandă prudența in utilizarea funcției cu orice date pe care nu doriți să le divulgați către terți, dacă există chiar și cea mai mică șansă ca o instrucțiune rău intenționată să se strecoare.

Pentru clienții enterprise care iau în considerare utilizarea Claude pentru documente comerciale sensibile, decizia Anthropic de a livra produsul cu vulnerabilități documentate sugerează că presiunea concurențială ar putea prevala asupra considerentelor de securitate în cadrul competiției intense dintre dezvoltatorii AI.

Această filosofie de tip „livrați mai întâi, securizați mai târziu” a provocat frustrări în rândul unor experți AI precum Willison, care a documentat pe larg, și a inventat termenul care le descrie, vulnerabilitățile de tip prompt injection-injecția promptului. Recent, el a descris starea actuală a securității AI ca fiind „îngrozitoare” pe blogul său, menționând că aceste vulnerabilități de injectare a prompturilor rămân răspândite „la aproape trei ani după ce am început să vorbim despre ele”.

Într-un avertisment previzibil din septembrie 2022, Willison a scris că „s-ar putea să existe sisteme care nu ar trebui construite deloc până când nu vom avea o soluție robustă”. Evaluarea sa recentă în prezent? „Se pare că le-am construit oricum!”