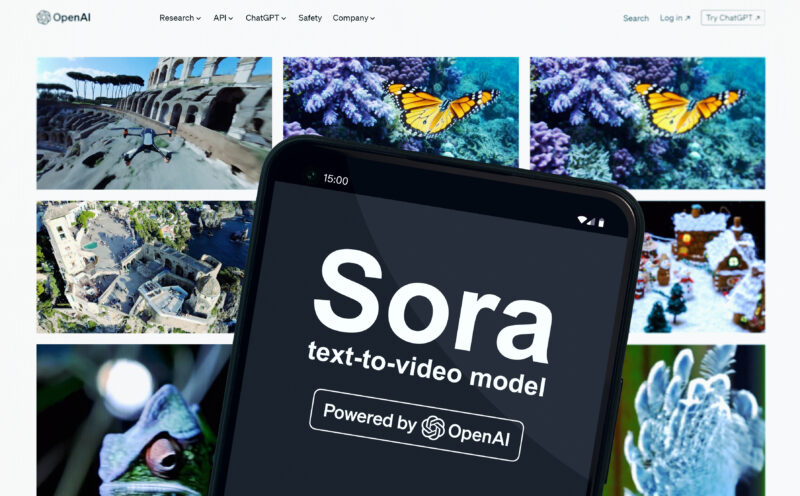

OpenAI a introdus noi instrumente de control în aplicația Sora, care le permit utilizatorilor să decidă cum și unde pot fi folosite versiunile lor generate de inteligență artificială. Actualizarea vine pe fondul criticilor privind conținutul generat de AI care inundă platforma, descrisă de mulți drept un „TikTok pentru deepfake-uri”, transmite TheVerge.

Urmărește cele mai noi producții video TechRider.ro

- articolul continuă mai jos -

Sora le oferă utilizatorilor posibilitatea de a crea videoclipuri scurte, de aproximativ zece secunde, în care pot apărea versiuni virtuale ale lor sau ale altor persoane — inclusiv vocea poate fi reprodusă. OpenAI numește aceste apariții „cameo-uri”, însă numeroși critici le consideră un potențial risc major pentru dezinformare și abuzuri online.

Bill Peebles, liderul echipei Sora din cadrul OpenAI, a explicat că noul sistem le permite utilizatorilor să restricționeze folosirea acestor versiuni generate de AI. „Utilizatorii pot decide ca dublurile lor virtuale să nu apară în clipuri care implică politică, să evite anumite expresii sau să fie excluse complet din anumite contexte”, a declarat Peebles.

Actualizarea permite și adăugarea unor preferințe de stil pentru versiunile AI ale utilizatorilor. Thomas Dimson, membru al echipei OpenAI, a oferit un exemplu amuzant: un utilizator ar putea seta ca dublura sa virtuală „să poarte o șapcă pe care scrie ‘#1 Ketchup Fan’ în fiecare videoclip”.

Noile măsuri fac parte dintr-un set mai amplu de actualizări lansate de OpenAI în weekend, care urmăresc să stabilizeze platforma și să reducă riscurile asociate cu utilizarea conținutului generat de inteligența artificială. Totuși, în pofida acestor eforturi, specialiștii avertizează că restricțiile pot fi ocolite cu ușurință. În trecut, alte instrumente AI, precum ChatGPT sau Claude, au fost folosite pentru a obține informații sensibile sau periculoase, în ciuda mecanismelor de siguranță existente.

Peebles a recunoscut că există provocări și a subliniat că OpenAI „lucrează la îmbunătățirea mecanismului de identificare” care semnalează conținutul generat de Sora, un sistem considerat până acum ineficient. „Vom continua să dezvoltăm restricțiile pentru a le face tot mai robuste și vom adăuga noi modalități prin care utilizatorii să își păstreze controlul asupra aparițiilor lor digitale”, a spus acesta.

Lansată de puțin timp, Sora a atras deja atenția prin volumul mare de conținut produs cu ajutorul AI, o parte dintre clipuri fiind controversate. Sistemul inițial de confidențialitate era limitat la câteva opțiuni simple — precum „prieteni”, „persoane aprobate” sau „oricine” — ceea ce a permis apariția unor situații neplăcute. Printre exemple se numără chiar cel al CEO-ului OpenAI, Sam Altman, care a devenit fără intenție subiectul mai multor videoclipuri ironice generate pe platformă, în care apare furând, cântând rap sau gătind un personaj fictiv.

Prin noile măsuri, OpenAI încearcă să reducă riscurile legate de folosirea abuzivă a tehnologiei și să ofere utilizatorilor un grad mai mare de siguranță și control. Totuși, succesul acestor instrumente depinde de eficiența cu care compania va reuși să prevină exploatarea lor greșită, într-un context în care conținutul generat de AI continuă să se răspândească rapid în mediul online.